很多团队在做天气数据采集时都会遇到一个“老大难”:明明请求很正常,却频繁被 Cloudflare 挡下来。

返回的不是天气页面,而是 403 错误、五秒盾,甚至无限验证循环。

这对依赖天气数据的行业来说简直是噩梦。物流需要预判雨雪天气;旅游要根据气象情况调整行程;能源行业更是离不开气象预测。

一旦采集不稳定,决策就容易失误。

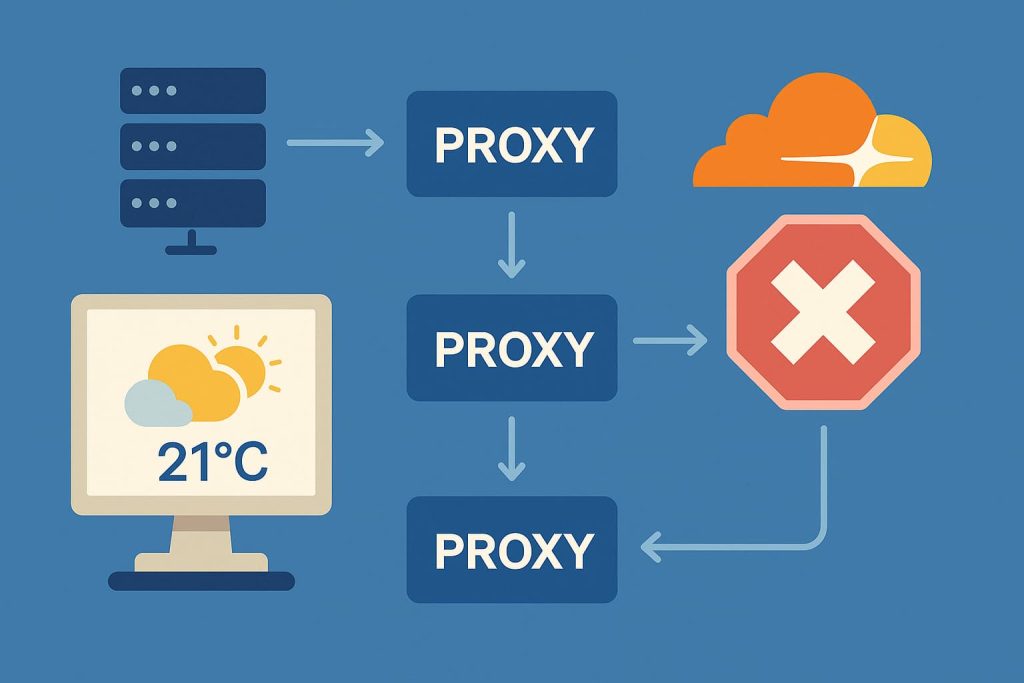

有没有办法用代理 API,特别是穿云API,来让采集过程更稳定?答案是肯定的。下面就一步步说清楚。

为什么天气网站容易触发 Cloudflare

和普通站点相比,天气类网站有几个特点:

- 访问频率高:很多人会频繁刷新天气,系统会重点监控高频请求。

- 跨区域访问多:不同城市、不同国家的数据,常常要从同一来源爬取。

- 数据价值大:天气数据牵涉广泛,容易被商业性采集,所以防护更严格。

结果就是,哪怕你只是采集个几十个城市的数据,也可能被判定成“异常流量”。

常见错误做法

- 直接用单一代理 IP:很快就被封,几乎撑不住几轮请求。

- 伪造请求头:虽然能骗过一部分检测,但五秒盾和 Turnstile 验证根本没用。

- 靠开源脚本硬解:像 cloudflare-scraper 这样的工具更新不及时,很容易失效。

- 拼命加重试:表面上能补点数据,实则效率低下,还可能加重封禁。

这些做法都解决不了根本问题。

代理API的作用

有一个做天气服务的创业团队,最开始用的就是常见的代理池。每天他们要采集全国 300 多个城市的天气数据,结果经常掉链子:有时整个华东地区的数据都缺失,只能人工补采。

后来,他们接入了穿云API,情况完全不一样了:

- 五秒盾再也不是绊脚石:原来脚本停在验证页,现在 API 自动完成挑战,返回的就是干净的 HTML。

- 跨境请求顺利多了:之前访问国外气象站点时,IP 一直被拦;换成 API 内置的全球代理,数据流畅拿到。

- 并发压力轻松应对:他们曾试过在暴雨预警期间同时拉取数十万条数据,API 依旧能稳定撑住,没有再出现大面积失败。

- 语言环境兼容:不管是 Python 的调度脚本,还是 Node.js 的数据分析模块,API 都能无缝接入。

用他们的话说:“以前每天都在修爬虫,现在终于可以安心研究天气模型了。”

实际配置思路

- 确定采集范围:按需选择目标城市,避免无意义的高频请求。

- 调用穿云API:将目标 URL 作为参数传递给 API,由它来负责处理验证。

- 分批任务调度:不要一次性跑完所有请求,可以分段执行。

- 结合代理池:如果任务量特别大,可以在穿云API的 V2 模式下接入自有代理,进一步提升稳定性。

- 设置错误重试:对偶尔的 503 或超时请求,配置合理的重试策略即可。

这种思路经过实践验证,稳定性比单靠代理池提升了一大截。

常见误区

- 误区一:只要代理多就能解决

代理只能解决部分问题,真正的难点是 JS 验证和流量指纹。 - 误区二:等待五秒就能绕过

爬虫不会自动执行验证逻辑,等再久也没用。 - 误区三:一次性采集所有数据最省事

实际上容易触发封禁,合理拆分任务才是关键。 - 误区四:开源库能长期稳定

更新速度跟不上 Cloudflare 的迭代,常常用着用着就失效。

FAQ

1.为什么采集天气网站特别容易触发验证?

因为访问频率高、流量模式固定,很容易被判定为爬虫流量。

2.穿云API 一定能保证采集成功吗?

它能处理大部分常见验证,但仍需合理控制频率和请求策略。

3.单个代理 IP 能不能长期稳定?

不行,短期或许能跑通,但长期几乎必封。

4.是否可以完全替代 Puppeteer?

在大多数大规模任务场景下可以,更高效稳定。

5.成本会不会太高?

比自己维护代理池和脚本成本低很多,尤其是长期任务更划算。

天气数据采集最怕的就是“不稳定”。一旦被 Cloudflare 卡住,数据就断档,后续分析全白费。

与其到处找代理、修脚本,不如直接用代理 API,尤其像穿云API这样成熟的方案,把五秒盾、验证循环都交给它来处理。

对依赖天气预测的行业来说,稳定采集不仅仅是效率问题,更是避免业务风险的关键。

选择合适的工具,就等于给决策加了一层保险。