在做音乐数据相关项目的人,大多迟早都会碰到 chordify.net。不管是做和弦分析工具、练耳产品、教学辅助,还是想把和弦数据结构化喂给模型,这个站点的覆盖面和解析质量都很有吸引力。但真正动手之后,问题并不在“怎么抓”,而在“怎么稳定地抓、长期地抓”。

很多人一开始用的思路都差不多:请求页面、解析 DOM、抽取和弦时间轴。刚开始成功率还行,跑几轮之后就开始出现各种异常:请求被重定向、返回空白 HTML、偶发 403、间歇性卡在加载态。排查到最后,结论往往很一致——不是代码逻辑问题,而是访问链路被拦截了。

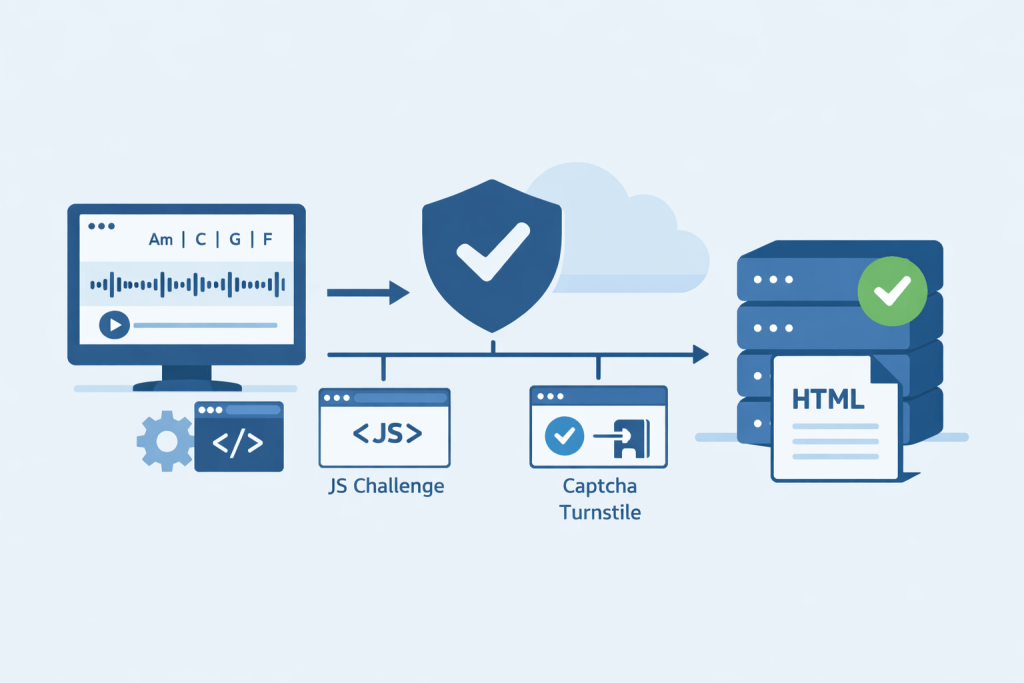

chordify.net 的防护并不算激进,但它的策略很典型:基于 Cloudflare 的 JS Challenge 与 Turnstile 校验,对“看起来不像真人浏览器”的请求进行延迟或直接拒绝。更麻烦的是,这类挑战不是每次都会触发,而是带有概率性,这就导致很多程序在测试环境一切正常,上线后却变得极不稳定。

一些人尝试过用全浏览器自动化去解决,比如直接起 Headless Chrome,等页面完全加载后再抓源码。这条路能跑,但成本极高:并发低、资源占用大、维护复杂,一旦规模放大,性价比迅速崩掉。也有人试图靠简单的 UA 轮换或代理池硬扛,结果是成功率看似上去了,但波动非常大,数据完整性没法保证。

真正靠谱的解决思路,其实来自对“验证本身”的处理,而不是对页面结构的投机取巧。Cloudflare 的核心逻辑是:通过 JS 执行、指纹校验、行为判断,确认你是不是一个“可信会话”,然后下发可复用的访问凭证。只要这个环节处理不好,后面的解析再优雅也没用。

这也是为什么不少做数据采集的老手,最后都会把验证处理单独拆出来。比如通过 穿云API 这种协议层方案,把 JS Challenge、Turnstile、甚至 Incapsula 的校验统一在请求前解决掉。对外表现仍然是普通的 HTTP 请求,但返回的已经是带有有效会话状态的 HTML 内容,包含完整 DOM 和可复用的 cf_clearance。

在 chordify.net 这种场景下,这种方式的优势非常明显。首先,请求链路稳定,不需要反复“撞运气”等挑战是否触发;其次,并发能力可以线性扩展,不会被浏览器实例数卡死;更重要的是,返回内容一致性高,便于后续解析和缓存。对需要长期跑任务的系统来说,这一点比单次成功率更重要。

从工程实践角度看,合理的架构通常是:入口统一走验证处理层,确保拿到干净 HTML;中间层只做结构解析与数据标准化;最外层再根据业务需要做缓存、重试和监控。这样一来,即使对方防护策略有小幅调整,也只需要在验证层做适配,不会牵一发动全身。

当然,任何方案都不是“万能钥匙”。合理控制请求频率、尊重站点负载、避免无意义的全量扫描,依然是长期能跑下去的前提。但至少在 chordify.net 这类站点上,把 Cloudflare 校验问题正面解决,已经能避免绝大多数“莫名其妙”的失败。

如果你现在的项目正卡在“偶尔能抓、但不稳定”这个阶段,建议不要再继续堆代理或调 UA 这种边角参数了。把验证问题抽离出来,用成熟的方案一次性处理干净,反而更省时间。对工程来说,稳定性本身,就是最重要的功能。