你肯定遇到过这种崩溃瞬间:只是把并发从 5 调到 8,或者把超时从 15 秒改成 10 秒,理论上应该“更快更稳”,结果却变成验证暴增、成功率下滑、延迟更高,甚至任务直接跑不动。最难受的是,程序没报错,你也说不出到底哪里坏了。

这篇文章只解决一个问题:为什么一个参数的小改动,会把结果拉到完全相反的方向。读完你会拿到一套能落地的排查顺序,知道该先看什么,再动什么,避免盲调。

一、先把话说透,参数不是旋钮,而是行为开关

很多人把参数当成“调节强度”的旋钮,但在数据采集、自动化访问、代理池管理这类系统里,参数更像行为开关。

你改的不是数字,你改的是系统在目标站点眼里的“样子”。

并发提高一点,等于访问密度变了。

重试多一次,等于失败后的行为变了。

间隔变短,等于节奏更固定更机械。

这些变化会触发新的风控判断,所以结果可能和预期完全相反。

二、为什么会出现“越调越反”的反直觉

这里有三个最常见的反直觉机制,很多团队都栽在这三点上。

1、参数牵动的是联动链路,不是单点

你以为只改了并发,实际被牵动的至少还有三件事。

第一,请求在同一时间窗口内更密集,失败密度会上升。

第二,代理池中好节点被更快消耗,差节点更容易混进关键路径。

第三,会话连续性更容易被打断,因为切换和重试会变频繁。

最后你看到的就是:成功率反而更差。

2、你把短期效果当成长期规律

参数改完,前 5 分钟可能更顺,这很容易让你误判。

但访问系统的判断是累积的。

当密度持续变高、轨迹持续变机械,风险评分上来后,验证就会变多,放行会变少。

于是你得到“前面更好,后面更糟”的典型曲线。

3、补救策略被你无意间放大成放大器

很多系统都有自动重试、自动切 IP、自动降级。

你改了一个参数,会导致这些补救动作触发得更频繁。

补救本来是兜底,频繁触发后就变成“异常放大器”。

最后你以为是站点变了,其实是系统行为变得更像攻击流量。

三、最常见的三个“参数陷阱”

如果你最近遇到“改一个值就崩”,通常在这三类参数里。

1、并发参数

并发不是速度,它首先是风险密度。

并发上去以后,验证比例、失败密度、单位请求成本几乎一定会上升,只是上升多少的问题。

2、重试参数

重试次数提高,短期成功率可能上升。

但中期会带来两个副作用:失败密度更高、节奏更机械。

如果你的失败原因不是偶发网络抖动,而是会话或验证问题,重试越多越糟。

3、IP切换频率

切换太慢,容易被同一身份累积风险。

切换太快,又会造成身份错位,会话连续性被破坏。

很多人把切换当万能解,结果反而把系统推向更严格的验证。

四、解决方案与策略,别再盲调,按顺序做

要避免“越调越反”,关键不是更聪明地调参数,而是先确认你在调什么行为。

1、先确认失败类型,再动参数

动作

把失败分成三类记录:超时、验证、拒绝访问。

判断标准

如果验证和拒绝占比在升,别先调并发,先处理会话和路径。

如果超时占比在升,才考虑超时与并发配合调整。

2、把参数当成“成组修改”,不要孤立改

动作

并发、间隔、重试一起评估,形成一个组合。

判断标准

改动后如果验证比例上升超过可接受范围,立即回退组合,而不是继续加码。

3、给参数设上限和冷却,避免连锁反应

动作

连续失败达到阈值就冷却,不要无限重试。

判断标准

失败密度能被压住,延迟曲线不再随着失败持续走高。

4、代理池先分层,再谈调参

动作

把代理按近期表现分高、中、低三层,关键任务只用高层。

判断标准

池子变大后成功率不反向下降,关键流程的波动明显减少。

五、穿云API在这种场景下能帮你省掉什么

很多“调一个参数就反转”的问题,本质是访问层变量太多、联动太乱:代理池质量不稳定、IP切换与会话不同步、验证处理分散在各处、失败补救互相叠加。

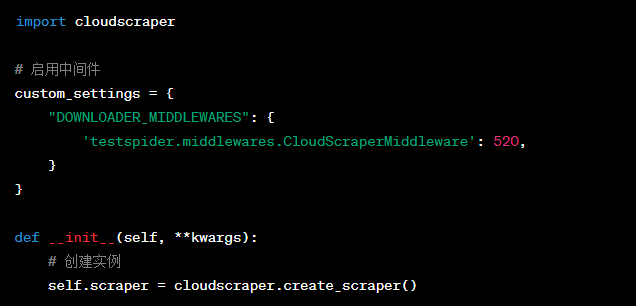

穿云API把代理池管理、自动IP切换、会话维护、验证处理与异常恢复集中在访问层收口,你的参数就不再承担“决定生死”的职责,而只是微调范围。

常见用法是:业务侧保留一个获取入口,传入目标URL与必要配置,直接拿回网页源码;底层完成代理调度、行为模拟与失败回收。这样你遇到问题时更容易判断是策略问题还是资源问题,调参也不会一调就把系统路径改乱。

六、挑战与未来展望

参数治理真正难的不是技术,而是习惯。多数团队习惯用参数救火,却很少把参数变更当成一次需要验证的行为实验。

未来更稳定的系统会走向两点:一是参数变更与行为指标绑定,二是访问策略自适应,自动把异常密度压回可控区间,而不是靠人工反复试值。

你改了一个参数,结果却完全相反,通常不是你“调错了数”,而是你无意间改写了访问行为链路。先分类失败,再成组调整,给补救设边界,代理池先分层,系统才会从玄学回到可控。