很多限制不是“突然拦死”,而是“慢慢变难”:先是偶发验证;再到内容降级、延迟拉长、连接更容易中断;最后才可能出现明确阻断。

这种“逐渐受限”最难定位,因为你不一定看到清晰错误提示,也很难判断是哪类信号在持续拉低信任。

这篇文章只解决一个问题:当业务访问逐渐受到限制时,Cloudflare 内部哪些判定信号最容易影响最终放行结果?

一、先给结论:放行结果通常由“分层评分 + 策略叠加”共同决定

Cloudflare 很少靠单一信号一刀切。

更常见的是:多类信号叠加形成风险评分;再按路径敏感度分层输出处置:

完整放行;轻量校验;限速/延迟;内容降级;显性挑战;最终阻断。

所以“逐渐受限”的本质是:请求被稳定推向更低信任层,而不是瞬间拉黑。

二、最容易影响最终放行结果的 8 类判定信号

1、身份连续性:会话能否稳定复用

系统确认不了“你是不是同一个访问者”,就会更保守。

常见触发点:Cookie/本地存储不稳定、重定向状态丢失、跨进程/容器导致状态不共享。

典型现象:刚通过下一跳又验证;跑久后验证频次缓慢上升。

2、访问主体稳定性:出口 IP/ASN/地区是否漂移

出口漂移会让你看起来“一直换人”,更容易被重新评估。

来源常见:企业 NAT 池轮换、云出口污染、移动网络切换、代理链不稳、多节点轮询。

现象:不同网络差异巨大;某些地区/运营商更容易受限。

3、请求特征一致性:请求头与客户端语义是否自然且稳定

系统看的不是 UA,而是“整套组合特征”。

高风险表现:关键头字段忽有忽无、顺序过机械、浏览器语义缺失、同链路出现多套指纹。

现象:不是每次都失败,但越跑越不稳定,常发生在跳转或新接口调用后。

4、路径敏感度:是否集中在高价值或易滥用端点

最终放行很大程度取决于“你访问什么”。

登录/搜索/下单/支付/账号接口/批量列表/数据密集型 API 往往更敏感。

现象:入口页正常,越接近关键链路越容易被验证、限速或降级。

5、访问上下文:是否像真实用户的导航链路

真实用户通常入口→导航→目标。

直奔目标接口或资源端点更容易落入“不确定区间”。

现象:某些接口/端点明显更容易触发验证,而首页或静态资源相对正常。

6、节奏与并发形态:突刺、机械规律、重复拉取

Cloudflare 不只看总量,更看短窗口形态。

两类高风险:瞬时突刺、固定间隔/固定顺序的机械规律。

现象:前期顺、后期慢慢变难;延迟、超时、限速逐步增加。

7、失败补救:重试与切换是否在放大风险

失败后密集重试、短窗口并发抬高、快速切换出口,容易被视为试探边界。

现象:异常集中在失败后的 1–5 分钟窗口;越救越严格。

8、内容一致性与响应质量:200 也可能是低信任输出

进入低信任层后,往往先出现“隐性变化”:模块缺失、字段被裁剪、延迟变长、连接更易中断。

现象:状态码正常但业务成功率下滑、数据变少、成本变高,却缺少明确拦截页。

三、为什么会“慢慢影响结果”:信号会被持续累积并用于分层

很多信号不是一次性裁决,而是持续记账:

会话越不连续、出口越漂移、失败补救越激进,越容易被推入更保守通道。

因此你看到的是“逐渐受限”,而不是“突然封禁”。

四、自检与排查:三条主线最快切出问题层级

主线一:内容一致性

对比结构与关键字段,而不是只看 200/403。

判断标准:200 但结构波动明显,优先按分层/降级定位,别先加重试。

主线二:身份连续性

固定会话与出口,小样本跑通一个流程。

判断标准:固定后稳定,说明问题主要来自会话断裂或出口漂移。

主线三:失败补救窗口

统计失败后短窗口的重试密度、并发突刺、切换频率。

判断标准:压平失败潮后,验证/中断应减少或后移;若越救越糟,说明补救在放大风险信号。

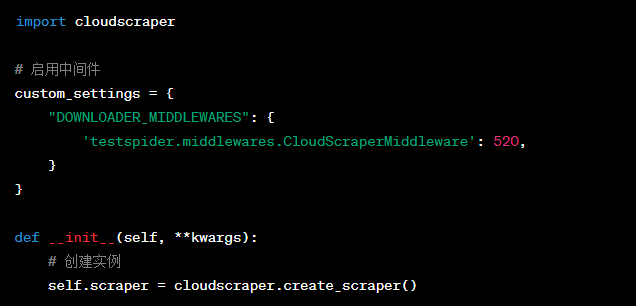

五、穿云API:把放行结果变稳定、可解释

业务访问逐渐受限,常见根因是访问语义不稳定:会话断裂、出口漂移、节奏突刺、失败后密集补救,会把请求一步步推向更保守的分层路径。

穿云API在访问层统一管理会话、出口与节奏,并以内容完整度与单位成功成本作为监控口径,更容易提前识别“评分在下滑”的趋势;同时减少漂移变量带来的误判,让受限问题更早暴露、更易回收。

当业务访问逐渐受到限制时,最常影响最终放行结果的信号集中在:会话连续性、出口稳定性、请求特征一致性、路径敏感度、上下文、节奏形态、失败补救,以及内容一致性。

判断是否真的稳定,不要只看状态码;更要看内容完整度与单位成功成本是否在上升。

把漂移变量收敛、把补救策略克制化,才能让访问长期停留在高信任层。